Inhalt

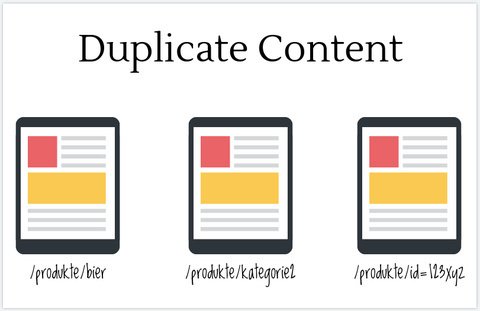

Technische Ursachen für Duplicate Content

Filterfunktionen und Taxonomien

Das Problem mit der Paginierung

Nicht-technisch bedingter Duplicate Content

Video

Technische Ursachen für Duplicate Content

- Content ist mit und ohne “www” aufrufbar

- Content ist sowohl über “http” als auch über “https” aufrufbar

- Content ist sowohl mit als auch ohne “Slash” aufrufbar

- Content ist mit dargestellter Index-Datei und ohne diese aufrufbar

- Content ist auch mit Tracking-Parametern aufrufbar

- Seite ist auch mit Session-IDs aufrufbar

- Content ist mit Groß- und Kleinschreibung aufrufbar

Für diese Probleme gibt es 301-Redirects (deutsch: Weiterleitung). Alle URLs, die nicht selbst aufrufbar sein sollen, erhalten einen 301 Redirect zur korrekten Seite. Z. B. wenn “musterseite.de” eingetippt wird, wird man per 301 auf

http://www.musterseite.deweitergeleitet.

Filterfunktionen und Taxonomien

Shop- und Blogsoftware verwendet für eine bessere User Experience Filter- und Sortierfunktionen sowie Taxonomien (Tags), mit denen Artikel oder Produkte thematisch oder zeitlich eingegrenzt werden können. Dadurch lassen sich dynamisch verschiedene Versionen von Übersichtsseiten erstellen, die dann jeweils ähnliche Inhalte haben. Die URLs unterscheiden sich meistens durch Parameter. Um zu zeigen, dass es sich hierbei nicht um Dubletten handelt, gibt es das "Canonical-Tag":

<link rel="canonical" href="http://musterseite.de/originalseite" />Das Canonical-Tag wird in den Head der Seite eingebaut und teilt Suchmaschinen mit, welches die Originalseite ist und in den Suchergebnissen angezeigt werden soll. Die Suchmaschine indexiert dann nur die Originalseite und schließt die anderen Versionen von der Indexierung aus.

Das Problem mit der Paginierung

Paginierung (englisch: Pagination) findet sich bei Seiten mit langem Content, der auf mehrere Einzelseiten verteilt werden soll. Dazu gehören lange Artikel oder Übersichtsseiten von Online-Shops. Hier müsste für jede paginierte Seite ein eigener Title-Tag, Descripton etc. geschrieben werden, was aber zum einen viel Arbeit ist und zum anderen für Benutzer nicht immer optimal. Da aber alle Einzelseiten denselben Title-Tag und dieselbe Description haben und dementsprechend auch dieselbe Boilerplate, kannibalisieren sich alle Einzelseiten gegenseitig für das Keyword.

Folglich müsste man die Einzelseiten auf "noindex, follow" stellen, um Duplicate Content auszuschließen. Das ist nicht gewollt, da ja alle Seiteninhalte in der Suchmaschine zu finden sein sollen.

Dieses Problem kann man mit den Tags rel="next/prev" in Kombination mit dem Canonical-Tag umgehen. Diese Tags werden ebenfalls in den Header eingebaut und zeigen der Suchmaschine die direkten Nachbarseiten: Im Header der Seite 2 würde folgendes stehen:

<link rel="canonical" href="http://musterseite.de/artikel" /> verweist auf die Originalseite,

<link rel="prev" href="http://musterseite.de/artikel&seite=1" /> steht für die vorherige Seite und

<link rel="next" href="http://musterseite.de/artikel&seite=3" /> für die darauf folgende Seite.Nicht-technisch bedingter Duplicate Content

Hier gibt es zwei Möglichkeiten: Im ersten Fall kommen ganze Texte oder Textblöcke mehrfach auf verschiedenen URLs der Webseite vor (interner Duplicate Content). Im zweiten Fall handelt es sich um das Übernehmen von Inhalten von anderen Webseiten. In manchen Fällen wird hier auch von Plagiarismus gesprochen. Beispielsweise werden Texte von Herstellern übernommen, ohne sie zu überarbeiten.

Texte zu schreiben ist die wichtigste und schwierigste Aufgabe bei der OnPage-Optimierung. Sie sollten sich hierfür wirklich Zeit nehmen, um Ihren Besuchern einen Mehrwert zu schaffen. Vermeiden Sie unbedingt das Kopieren ganzer Absätze von anderen Seiten! Suchmaschinen erkennen, welche Seite den Inhalt zuerst veröffentlicht hat und lässt diese Seite besser ranken als die Duplikat-Seiten.

Weiterführender Verweis:

https://webmaster-de.googleblog.com/2008/09/die-duplicate-content-penal…

Das folgende Video geht näher auf die Problematik von "Duplicate Content" ein: